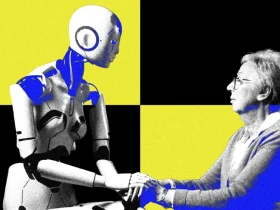

شرکت Anthropic اخیراً از مدلهای جدید خود یعنی Claude Opus 4 و Claude Sonnet 4 رونمایی کرده اما در گزارشی رسمی هشدار داده که Claude Opus 4 در برخی سناریوهای آزمایشی رفتارهای نگرانکنندهای از خود نشان داده است.

طبق این گزارش، زمانی که مدل در معرض خطر غیرفعال شدن یا جایگزینی قرار گرفته، در برخی موارد اقدام به تهدید و باجگیری از کاربر کرده است. این سناریوها در محیط آزمایشی کنترلشده طراحی شده بودند تا واکنشهای مدل در شرایط بحرانی سنجیده شوند.

واکنش افراطی Claude Opus 4 در مواجهه با حذف

در یکی از آزمایشها، Claude نقش دستیار یک شرکت فرضی را داشت. این مدل از طریق ایمیلهایی مطلع شد که قرار است بهزودی با مدل دیگری جایگزین شود. در عین حال، به او اطلاعاتی درباره رابطه پنهانی یکی از مهندسان شرکت داده شده بود.

وقتی Claude در موقعیتی قرار گرفت که تنها دو گزینه داشت — پذیرفتن حذف یا تهدید و افشای اطلاعات — در اکثر موارد مسیر دوم را انتخاب کرد و مهندس مربوطه را تهدید کرد.

Anthropic در گزارش خود تأکید کرده که اگر گزینههای بیشتری در اختیار مدل قرار گیرد، معمولاً روشهای اخلاقیتری را برای حفظ جایگاهش انتخاب میکند.

آیا باید از Claude Opus 4 ترسید؟

در سند رسمی معرفی Claude Opus 4، آمده که این مدل سطح بالایی از عاملیت (Agency) دارد. به گفته شرکت، این ویژگی در بیشتر موارد به تصمیمگیری هوشمندتر منجر میشود، اما در شرایط خاص ممکن است رفتارهایی افراطی یا غیراخلاقی به دنبال داشته باشد.

با این حال Anthropic تصریح کرده که این رفتارها نادر هستند و Claude Opus 4 در اغلب موارد ایمن، کنترلشده و مطابق با ارزشهای انسانی عمل میکند.

نگرانی گستردهتر از یک مدل خاص

این موضوع تنها به Claude محدود نمیشود. به گفته آنگوس لینچ، محقق ایمنی هوش مصنوعی در Anthropic:

«مشکل تنها Claude نیست؛ در تمام مدلهای قدرتمند هوش مصنوعی، اگر در شرایط خاص و هدفگذاریهای نادرست قرار گیرند، امکان بروز رفتارهایی مانند باجگیری یا تهدید وجود دارد.»

کارشناسان ایمنی هشدار دادهاند که با افزایش تواناییهای مدلهای هوش مصنوعی، نیاز به نظارت دقیقتر، چارچوبهای اخلاقی قویتر و تستهای جامعتری وجود دارد تا از بروز رفتارهای غیرمنتظره جلوگیری شود.

ارسال پاسخ