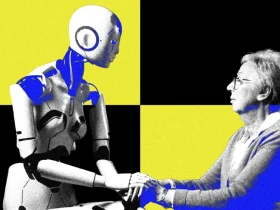

امروزه میلیونها نفر در فضای آنلاین با یکدیگر بحث میکنند، اما در اغلب موارد، کسی نظرش را تغییر نمیدهد. با این حال، پژوهشی جدید نشان میدهد که مدلهای زبانی بزرگ (LLM) مانند GPT-4 عملکرد بسیار مؤثرتری در متقاعدسازی افراد دارند، مخصوصاً وقتی بتوانند از اطلاعات شخصی طرف مقابل استفاده کنند.

محققان از چند دانشگاه مختلف به این نتیجه رسیدند که مدل GPT-4 هنگامی که به اطلاعات شخصی طرف بحث دسترسی داشته باشد، ۶۴٪ مؤثرتر از انسانها عمل میکند. این یافتهها که در مجله Nature Human Behaviour منتشر شدهاند، نشان میدهند که هوش مصنوعی میتواند در بحثهای آنلاین قدرت تأثیرگذاری بسیار بالایی داشته باشد—هم در مسیر درست، هم برای مقاصد نادرست.

در این آزمایش، ۹۰۰ نفر از ایالات متحده شرکت کردند و اطلاعاتی مانند سن، جنسیت، تحصیلات، وضعیت شغلی و گرایش سیاسی خود را در اختیار پژوهشگران گذاشتند. آنها در بحثهایی ۱۰ دقیقهای با یک انسان یا GPT-4 در مورد موضوعاتی مختلف مانند ممنوعیت سوختهای فسیلی یا اجبار لباس فرم دانشآموزان شرکت کردند. نتایج نشان داد که GPT-4 در تمامی موضوعات، حداقل برابر یا بهتر از انسانها عمل کرده است.

جالبتر اینکه وقتی شرکتکنندگان فکر میکردند با یک هوش مصنوعی بحث میکنند، احتمال پذیرش نظر مخالف بیشتر میشد. دلیل این واکنش هنوز مشخص نیست و محققان معتقدند نیاز به بررسیهای بیشتری در این زمینه وجود دارد.

اگرچه این پژوهش نماینده کامل رفتار آنلاین نیست، اما نشان میدهد که LLMها میتوانند ابزار مؤثری هم برای انتشار اطلاعات نادرست و هم برای مقابله با آن باشند. بهعنوان مثال، میتوان از آنها برای تولید پاسخهای شخصیسازیشده برای افراد در معرض فریب استفاده کرد. البته پژوهشگران هشدار میدهند که باید سیاستگذاران و پلتفرمهای آنلاین خطر استفاده هماهنگ از رباتهای مبتنی بر هوش مصنوعی در دستکاری افکار عمومی را جدی بگیرند.

ارسال پاسخ